摘要:在Deepseek-R1-ZERO时代来临之际,尽管面临挑战,但无人尝试放弃微调对齐。这是因为强化学习构建的思考链推理模型具有强大的潜力,能够通过不断学习和优化,提高系统的决策能力和适应性。微调对齐是确保模型性能和稳定性的重要步骤,对于实现高效、准确的推理至关重要。研究人员继续探索这一领域,以期在无人系统领域取得更大的进展。

目录导读:

在人工智能领域,深度学习和强化学习是两大重要的机器学习技术,随着科技的不断发展,这两者结合的应用逐渐成为研究热点,而在Deepseek-R1-ZERO出现之前,为何无人尝试放弃微调对齐,通过强化学习生成思考链推理模型呢?本文将就此话题展开讨论。

微调对齐的挑战性

在传统的机器学习和深度学习模型中,微调对齐是一个重要的环节,随着数据规模的扩大和模型复杂度的提升,微调对齐的难度和成本也在不断增加,这不仅需要大量的计算资源,还需要专业人员的精细调整,放弃微调对齐成为了许多研究者追求的目标。

强化学习的优势

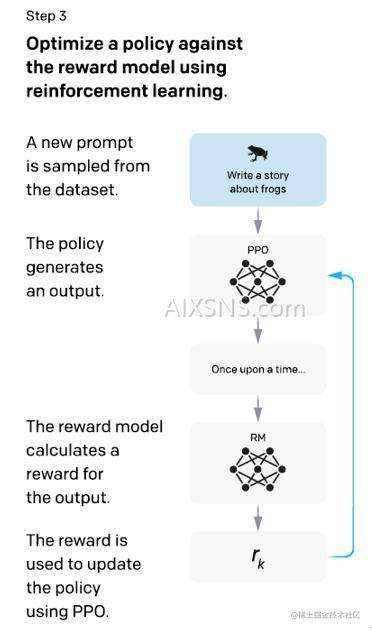

强化学习是一种通过智能体(agent)与环境交互,学习完成任务的方法,与传统的监督学习和深度学习相比,强化学习具有更强的自适应能力和鲁棒性,在构建思考链推理模型时,强化学习可以通过智能体不断地与环境交互,学习如何做出决策,从而生成具有推理能力的模型。

结合强化学习与深度学习的必要性

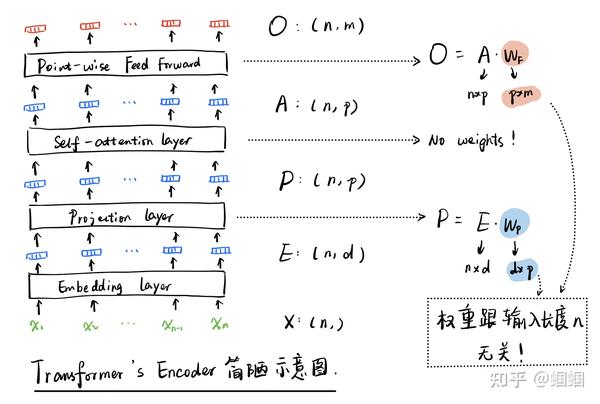

虽然深度学习在许多领域取得了巨大的成功,但在某些任务上,如推理、决策等,还需要结合强化学习的优势,通过结合深度学习和强化学习,可以构建出更加智能的模型,解决传统模型难以解决的问题,特别是在面对复杂任务时,结合两者优势的模型能够展现出更强的性能。

Deepseek-R1-ZERO的背景

Deepseek-R1-ZERO是新一代的人工智能系统,它结合了深度学习和强化学习的优势,实现了强大的推理和决策能力,在Deepseek-R1-ZERO出现之前,虽然无人尝试放弃微调对齐,但通过强化学习构建思考链推理模型的研究已经取得了一定的成果,这些研究成果为Deepseek-R1-ZERO的研发提供了重要的基础。

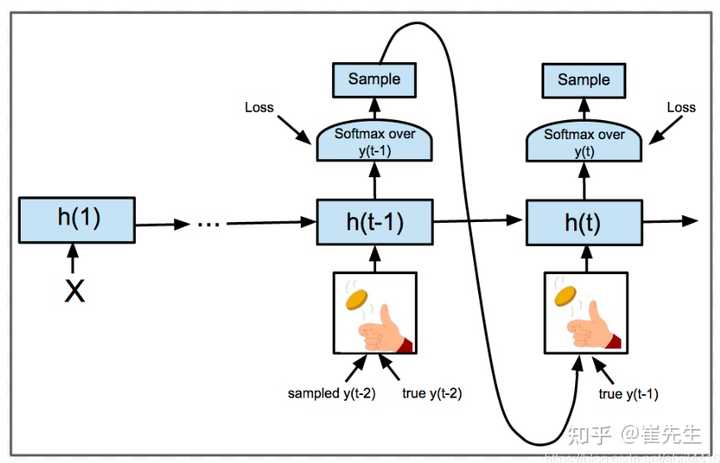

强化学习与思考链推理模型的融合过程

在Deepseek-R1-ZERO之前的研究中,研究者们尝试将强化学习与深度学习相结合,构建思考链推理模型,他们通过设计智能体,使其能够在环境中自主学习任务,并通过不断地实践和学习,生成具有推理能力的模型,在这个过程中,强化学习起到了关键的作用,帮助智能体做出决策并优化行为。

面临的挑战与问题

尽管强化学习与深度学习的结合具有巨大的潜力,但在实践中仍面临一些挑战和问题,如何设计有效的智能体、如何优化奖励函数、如何处理高维数据等,强化学习的训练过程通常需要大量的时间和计算资源,这也是一个需要解决的问题。

八、Deepseek-R1-ZERO的贡献与启示

Deepseek-R1-ZERO的出现为人工智能领域带来了新的突破,它通过结合深度学习和强化学习的优势,实现了强大的推理和决策能力,Deepseek-R1-ZERO的研发过程也为我们提供了宝贵的启示:在未来的研究中,我们需要更加注重模型的自适应能力和鲁棒性,结合多种机器学习的优势,构建更加智能的模型。

未来展望

随着科技的不断发展,我们相信未来会有更多的研究者和团队尝试结合深度学习和强化学习,构建更加智能的模型,随着计算资源的不断丰富的算法的不断优化,放弃微调对齐将成为可能,我们将期待更多创新的研究成果,推动人工智能领域的发展。

Deepseek-R1-ZERO的出现为我们展示了结合深度学习和强化学习的巨大潜力,在未来的研究中,我们需要不断探索新的方法和技术,结合多种机器学习的优势,构建更加智能、鲁棒性更强的模型,我们也需要关注模型的自适应能力和可解释性,为人工智能的发展提供更为坚实的基础。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号