摘要:本教程详细介绍了DeepSeek R1推理模型的本地部署过程,实现断网状态下的运行,以保障用户隐私安全。该模型可广泛应用于各种应用场景,提供强大的推理能力。本教程具有保姆级别的详细程度,即使对于初学者也能轻松上手。

目录导读:

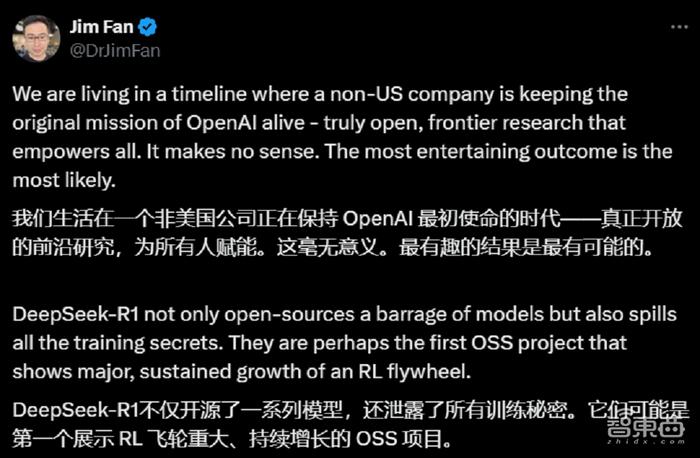

随着人工智能技术的飞速发展,大语言模型的应用越来越广泛,DeepSeek R1推理模型作为最新一代的杰出代表,以其强大的性能和灵活的部署方式赢得了广泛关注,本文将为大家呈现一份详尽的DeepSeek R1推理模型本地部署保姆级教程,帮助用户轻松在本地环境中使用DeepSeek R1进行推理,实现断网运行,无惧隐私威胁。

DeepSeek R1推理模型概述

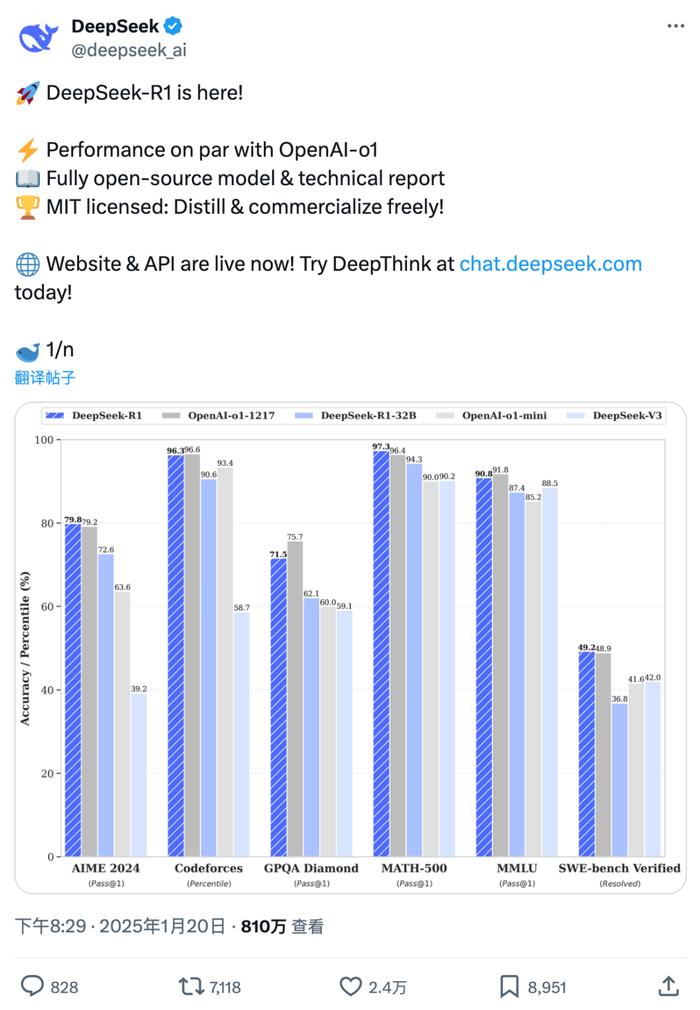

DeepSeek R1是一款高效、智能的推理模型,适用于多种应用场景,它支持CPU和GPU混合推理,能根据实际需求自动调整计算资源,实现高性能的推理任务,DeepSeek R1还具备出色的可部署性,支持完全本地部署,方便用户在没有网络连接的环境下使用。

完全本地部署的步骤

1、系统准备:确保本地环境满足DeepSeek R1的硬件和软件要求,包括操作系统、内存、显卡等。

2、下载与安装:从官方渠道下载DeepSeek R1推理模型安装包,按照指引进行安装。

3、配置环境:配置必要的环境变量和依赖库,确保模型能够正常运行。

4、部署模型:将DeepSeek R1模型文件放置在指定目录,完成模型部署。

断网运行,保护隐私安全

DeepSeek R1支持完全本地部署,用户可以在本地环境中独立完成推理任务,无需将数据传输到云端或其他远程服务器,这不仅提高了数据安全性,还避免了隐私泄露的风险,在断网状态下,DeepSeek R1依然可以正常运行,保证数据的私密性。

大语言模型推理时的调参

DeepSeek R1作为一款大语言模型,在推理过程中可以根据实际需求进行参数调整,用户可以根据模型的性能表现,对批次大小、学习率、优化器等参数进行优化,以获得更好的推理效果。

CPU与GPU混合推理

DeepSeek R1支持CPU和GPU混合推理,能够根据计算需求自动分配任务,在资源充足的情况下,GPU可以加速模型的运算速度;在资源有限的情况下,CPU可以接管部分计算任务,保证推理的顺利进行,这种灵活的分配方式使得DeepSeek R1能够适应不同的硬件环境,提高推理效率。

32B轻松本地部署

DeepSeek R1推理模型的本地部署过程简单易行,即使对于普通用户来说也能轻松完成,只需按照官方教程的步骤进行操作,即可在32B环境下完成模型的本地部署,开始使用DeepSeek R1进行推理任务。

教程支持与社区帮助

在使用过程中,如遇到任何问题,用户可以通过官方教程、社区论坛等渠道获取帮助,官方提供了详细的教程和文档,帮助用户解决部署和使用过程中可能遇到的问题,社区论坛则为用户提供了一个交流的平台,用户可以分享经验、提问和寻求帮助。

本文为大家介绍了DeepSeek R1推理模型的完全本地部署保姆级教程,包括模型概述、部署步骤、断网运行、调参、CPU与GPU混合推理、轻松部署等内容,通过本文的指导,用户可以在本地环境中轻松使用DeepSeek R1进行推理,实现断网运行,保护隐私安全。

展望

随着技术的不断发展,DeepSeek R1推理模型将在更多领域得到应用,DeepSeek R1将继续优化性能,提高部署效率,为用户提供更便捷、安全的推理体验,官方将不断完善教程和社区支持,帮助更多用户顺利使用DeepSeek R1推理模型。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号